Votre utilisation de l’IA au bureau peut mettre votre entreprise en danger, préviennent les experts

La prolifération des outils basés sur l’intelligence artificielle dans les bureaux a ouvert une nouvelle vulnérabilité dans le réseau d’entreprise.

Votre chatbot alimenté par l’IA met-il votre bureau en danger ? L’adoption de nombreux outils basés sur l’intelligence artificielle dans les entreprises et les gouvernements a créé de nouveaux risques pour la sécurité des réseaux. Des entreprises comme Samsung interdisent désormais l’utilisation de ChatGPT en interne pour cause : les ingénieurs de la division semi-conducteurs avaient utilisé l’agent conversationnel en lui fournissant un code source confidentiel qu’ils souhaitaient améliorer. On peut également citer la ville de Montpellier qui a appliqué les mêmes consignes et blocages aux postes d’employés municipaux. La crainte serait toujours la même : les salariés fournissent trop d’informations sensibles à ChatGPT.

De nombreux grands groupes ont donc privilégié une approche différente : développer leur propre intelligence artificielle interne, en s’appuyant sur les bases « métiers » de ChatGPT ou Claude. Des données parfois hébergées localement, des collaborateurs qui optimisent l’outil interne, tout semble impeccable en théorie. Sauf que cet outil, comme d’autres, est hackable. Et le gain peut être d’autant plus intéressant une fois que le cybercriminel a volé l’accès à ce programme proposé à tous les salariés.

Concrètement, quels sont les risques ? » Si un hacker a accès au compte professionnel d’un chatbot populaire, il pourra retrouver des documents sensibles qui y sont transférés ou encore l’historique des discussions. », explique Adrien Merveille, expert en cybersécurité chez Check Point. » Un programme développé en interne n’est pas non plus à l’abri. Le cybercriminel peut tenter d’empoisonner le code pour modifier les résultats produits par une IA et nuire à l’entreprise. » ajoute le spécialiste. Une entreprise qui analyse les images d’une caméra pourrait par exemple se tromper dans les analyses fournies par son programme.

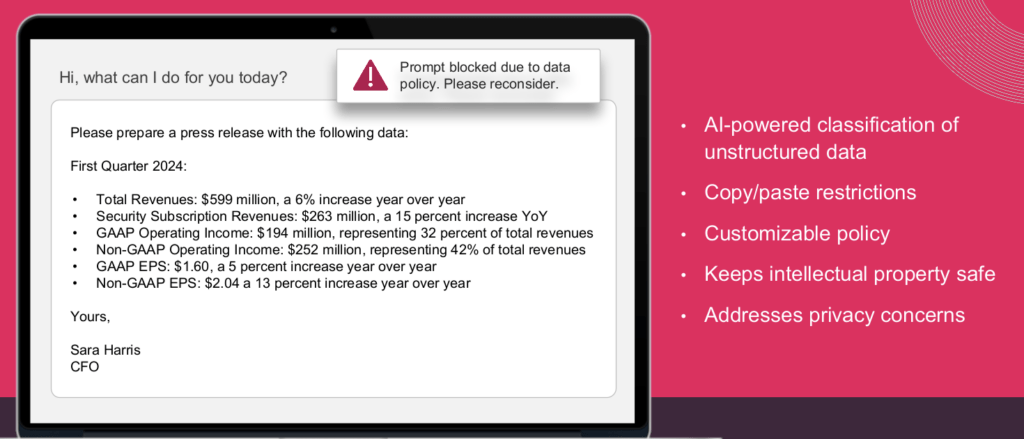

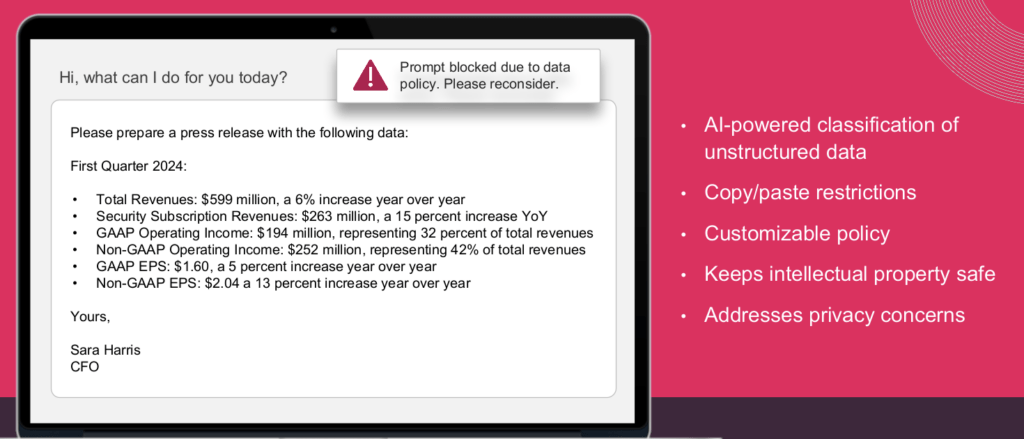

Modules pour bloquer les requêtes vers ChatGPT

Cyberattaques : quand l’humain est le maillon faible

Avec U-Cyber 360°, la société française Mailinblack vous permet de protéger votre organisation et de sensibiliser vos collaborateurs à la cybersécurité.

Du gestionnaire de mots de passe à la sécurité des emails, en passant par la formation continue et les simulations d’attaques, cette solution rassemble tous les outils pour prévenir les cyber-risques.

Des solutions commencent à émerger pour sécuriser ces nouveaux outils internes. La société Check Point propose désormais des modules sur les moteurs de recherche permettant de bloquer les requêtes d’un collaborateur sur ChatGPT lorsqu’il divulgue des informations privées.

Si vous demandez une synthèse basée sur les résultats des différentes branches de l’entreprise, celle-ci sera bloquée car elle contient des informations considérées comme sensibles.

L’ANSSI, la sentinelle chargée de la protection numérique de l’administration française, s’est également penchée sur le sujet et a mis à disposition au printemps dernier une brochure en ligne pour sécuriser l’usage de l’IA en entreprise.

» L’erreur la plus fondamentale est de croire que l’intelligence artificielle est un sujet à part, au point d’oublier que les règles de sécurité ne s’appliquent pas à son utilisation. » prévient Vincent Strubel, directeur général de l’ANSSI. » On remarque quelques erreurs en pratique, une IA qui se rafraîchit en ligne, qui n’est pas surveillée… avant de laisser le programme prendre une décision, on recommande de bien le maîtriser. » nous explique-t-il.

Pour avancer, l’ANSSI envisagerait que les labels utilisent des programmes sécurisés d’intelligence artificielle. Ces certifications nationales existent déjà pour les solutions de cybersécurité, mais il reste encore à trouver les critères d’une IA sûre.

En attendant, vous pouvez toujours demander à ChatGPT de ne pas conserver l’historique des discussions pour éviter d’alimenter son IA.