DLSS 4 s’améliore sur de nombreux aspects cette année, et nous devons cette évolution majeure à une nouveauté majeure : l’adoption du modèle Transformer. Nous vous expliquons comment la technologie Nvidia fait un nouveau bond en avant.

Nvidia a profité de l’annonce de ses prochaines cartes graphiques GeForce RTX 50 pour dévoiler DLSS 4, la nouvelle version majeure de sa boîte à outils IA pour augmenter les performances de vos jeux. On ne parle plus de Super Résolution (ou upscaling), mais aussi de génération d’images et de reconstruction de rayons.

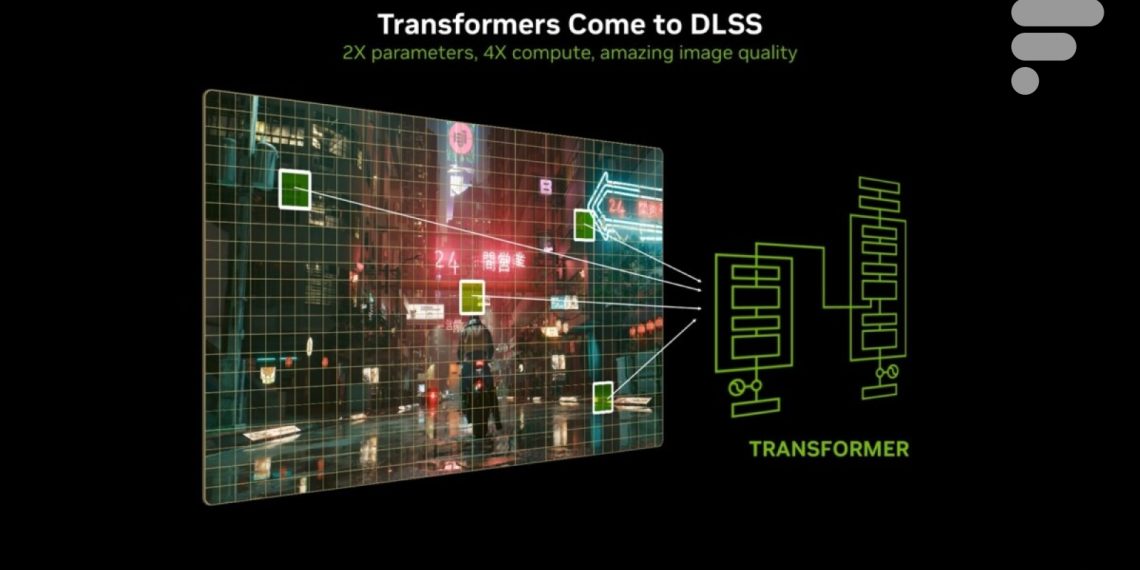

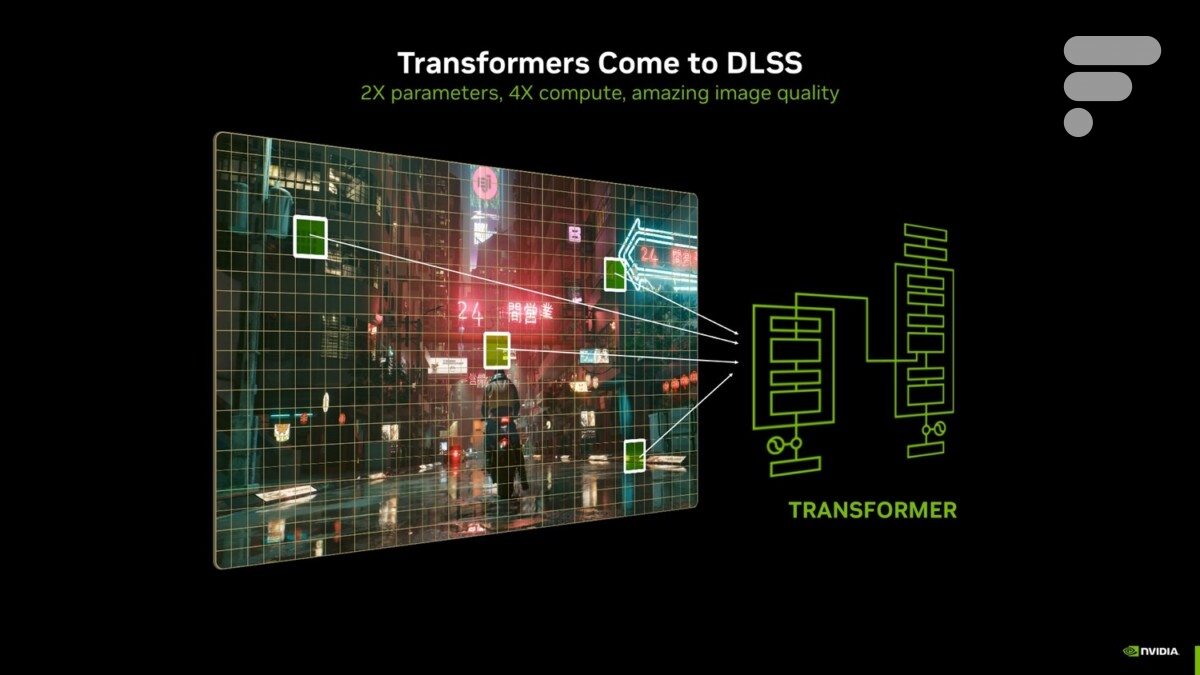

C’est Bryan Catanzaro, le grand homme du Deep Learning chez Nvidia, qui l’a déclaré : il s’agit de la mise à jour la plus importante du DLSS depuis 2020. La grande nouveauté réside dans l’adoption d’un tout nouveau modèle, le Vision Transformer. Nous vous expliquons comment cela fonctionne et surtout en quoi cela change la donne pour le DLSS.

DLSS 4 va à Vision Transformer

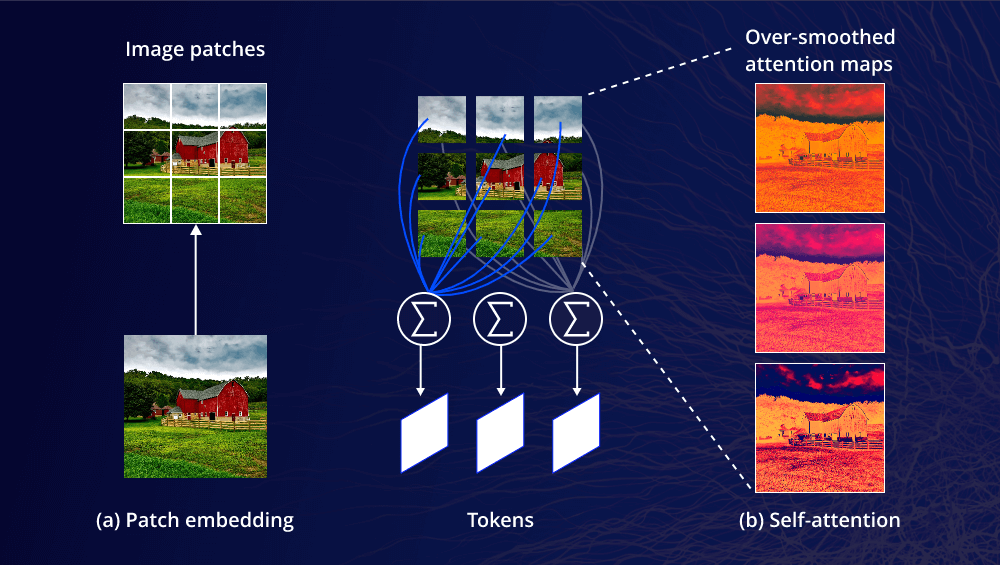

Jusqu’à présent, le DLSS exploitait un réseau de neurones convolutifs ou CNN (convolutional neural network), qui fonctionnait sur la base d’une agrégation locale de données, en analysant des zones spécifiques de l’image sur plusieurs images successives. C’est d’ailleurs le choix adopté par Sony pour sa technologie PSSR sur PS5 Pro ainsi que la base de travail du Project Amethyst pour la future PS6.

DLSS 4 adopte désormais le modèle Vision Transformer, beaucoup plus récent, basé sur le modèle Transformer utilisé dans des applications comme ChatGPT ou encore Sora, l’IA générative vidéo d’OpenAI. Ce nouveau modèle utilise un mécanisme dit d’auto-attention, qui permet d’évaluer l’importance de chaque pixel au sein d’une même image, toujours sur plusieurs images successives. Cela permet à DLSS 4 d’avoir une meilleure compréhension des scènes 3D les plus complexes en se concentrant sur les détails et les éléments les plus complexes à reconstruire à la définition native de votre écran.

Selon Bryan Catanzaro lors d’un briefing en présence de Frandroid au CES de Las Vegas, le modèle Transformer est « beaucoup plus stable » et peut « être formé sur des ensembles de données beaucoup plus volumineux « . S’il est plus économe en énergie, cela permet à Nvidia de quadrupler sa puissance de calcul par rapport aux versions précédentes. Et pour les joueurs, les bénéfices sont nombreux.

Ce qu’apporte ce nouveau modèle

En exploitant un modèle capable d’analyser les zones les plus complexes d’une image pour y concentrer sa puissance de calcul, DLSS 4 peut en théorie s’affranchir de certaines limites de la technologie. Tous les aspects du DLSS sont concernés : Super Résolution, Frame Generation, Ray Reconstruction et même DLAA, la solution d’antialiasing de Nvidia.

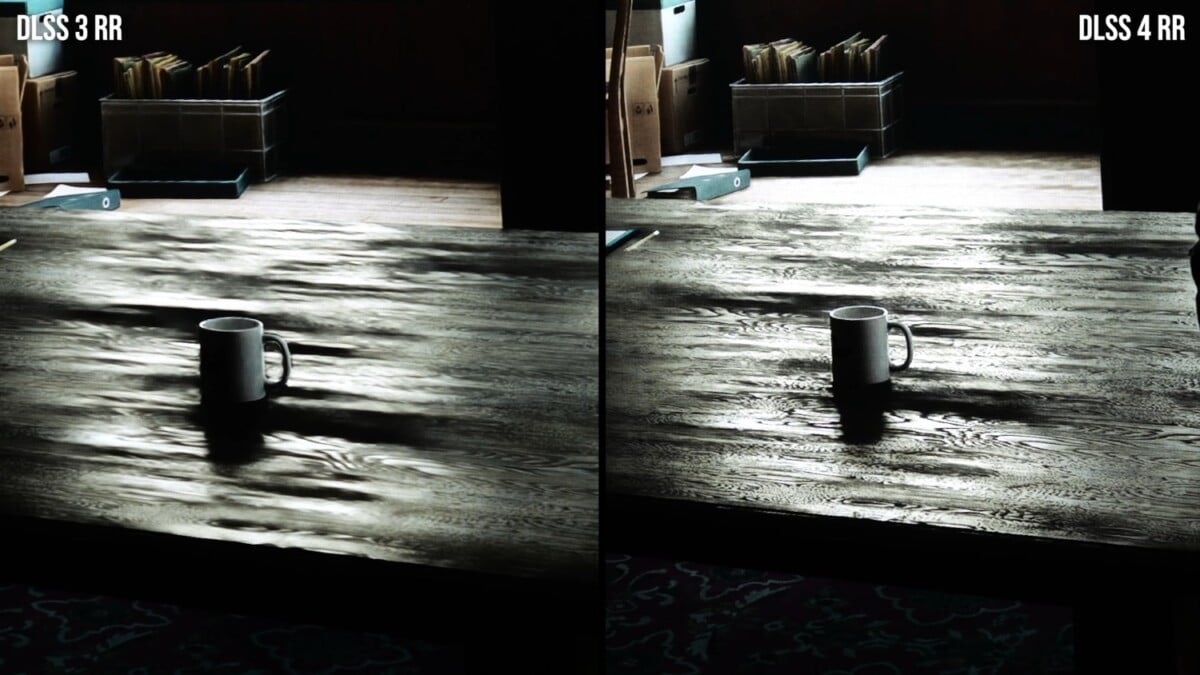

Les différentes démonstrations de Nvidia nous ont en effet montré des phénomènes de flickering ou de ghosting parfois éliminés sur des éléments comme des grilles ou des ventilateurs dans Alan réveil 2 Et Ratchet & Clank : Faille à part. Globalement, on peut donc s’attendre à une meilleure stabilité temporelle de l’image dans les scènes les plus complexes à « reconstruire » par le modèle.

Avec une meilleure compréhension de la scène et de ses différents éléments, le modèle Vision Transformer améliore la reconstruction de l’image, à savoir le upscaling de la définition interne vers la définition native de votre écran. En attendant de pouvoir tester plus en détail, nous avons déjà pu en faire l’expérience au CES de Las Vegas, sur des jeux comme Cyberpunk 2077 Et Alan réveil 2.

La qualité globale de l’image, en particulier dans les scénarios de lancer de rayons et de tracé de chemin, semble avoir fait un bond en avant. Dans ce contexte, les modes Performance et Ultra Performance gagnent en clarté, ce qui s’avère très utile pour les jeux les plus gourmands. En attendant de pouvoir tester plus en détail, le modèle Transformer permet au DLSS de Nvidia de prendre encore une avance considérable sur ses concurrents, malgré un FSR4 prometteur d’AMD.