Le 11 octobre 1999, le petit monde des cartes graphiques connaît un bouleversement : la Nvidia GeForce 256. Le début d’une révolution pour l’industrie informatique grand public, mais pas seulement. Entre jeux vidéo, cryptomonnaies et configurations puissante, rétrospective sur le point de départ d’une série iconique : la GeForce.

Le 11 octobre 1999 est sortie la Nvidia GeForce 256, considérée comme la première carte graphique grand public (GPU) au monde. Aujourd’hui marque l’anniversaire de sa sortie, il y a vingt-cinq ans. Une carte qui a déjà un quart de siècle et qui est désormais à des années lumières de ce qui se fait de mieux actuellement. Dans quelques mois, ce devrait être au tour de la Nvidia GeForce 50XX de faire son apparition.

PC et jeuça rime pour Nvidia

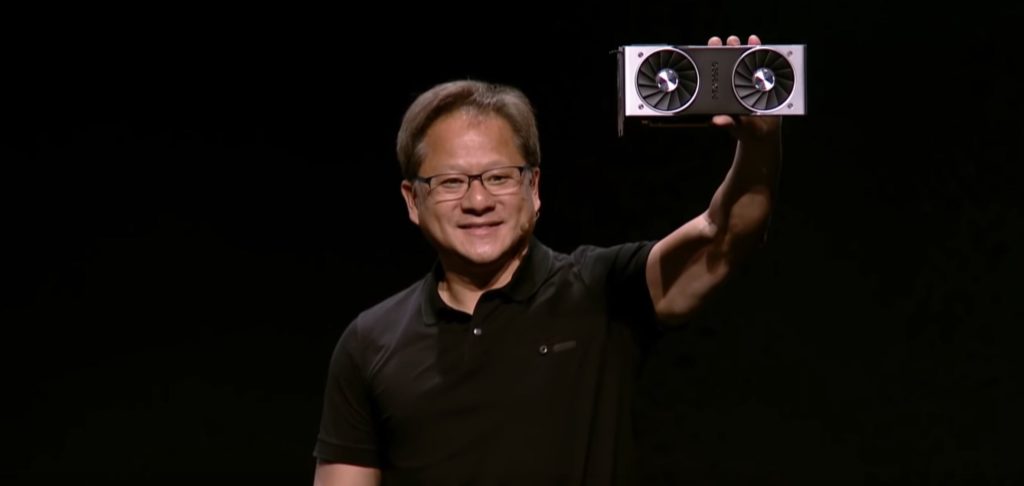

En 1993, Jensen Huang, Chris Malachowsky et Curtis Priem fondent Nvidia avec une vision : l’ordinateur, le Ordinateur personnel (PC), sera une pièce indispensable pour jouer aux jeux vidéo. Il y a bien plus dans la vie que de simples consoles de salon (ou portables). De plus, les jeux vidéo connaîtront une accélération de la qualité graphique. C’est sûr : le matériel doit pouvoir « suivre » afin de jouer correctement et de bénéficier des avancées techniques. Le 31 août 1999, ils présentent leur première gamme de cartes graphiques qui ouvriront la gamme GeForce.

Déjà à l’époque, les archives médiatiques montraient l’intérêt médiatique pour cette GeForce 256 : HardWare.com (depuis inactif) lui a consacré plusieurs articles. » La GeForce 256 est, comme son nom l’indique, entièrement 256 bits, et c’est une première dans le domaine des puces grand public. », pouvait-on lire. Et pour le nom GeForce, il vient de l’expression Force géométriquepuisqu’il s’agissait de la première carte graphique à calculer la géométrie de transformation et d’éclairage. Avant, c’était au processeur de s’en charger.

Cette transition était justement la philosophie de Nvidia avec ses GPU (Graphics Processing Unit) : décharger les processeurs en gérant l’affichage vidéo et la 3D, pour avoir de meilleures performances. C’est pourquoi on considère généralement la GeForce 256 comme la « la première carte graphique au monde », car c’était le point de départ du GPU pour le grand public.

La Nvidia GeForce 256 n’est pas vraiment la première carte graphique au monde

L’histoire a fait que nous ne nous souvenons presque que de Nvidia. Cependant, la GeForce 256 n’est pas la première véritable carte graphique à proprement parler. Il y avait des cartes graphiques avant la marque, au sens de composants qui se connectent à un PC de bureau dès le milieu des années 1980. Mais, à cette époque, ils ne pouvaient afficher que des caractères 8 bits, en monochrome et bien évidemment en 2D.

Petit à petit, les tâches graphiques sont abandonnées par les processeurs au profit de ces cartes. Puis, dans les années 1990, les GPU ont commencé à gérer la 3D, comme les cartes 3DX, ou 3dfx Voodoo. Les premières à pouvoir traiter à la fois la 2D et la 3D dans un même circuit intégré furent les cartes ATI et la Verite de Rendition apparues en 1996.

On peut aussi parler des Nvidia RIVA 128 et RIVA TNT2, qui sont les prédécesseurs de la GeForce 256. Cette dernière a apporté des améliorations matérielles pour augmenter les performances sur les jeux 3D sur PC : elle a également été la première à disposer d’un accélérateur 3D entièrement compatible avec Direct3D. . Alors, si l’on retient souvent la GeForce 256 comme la « la première carte graphique au monde « , c’est aussi parce que Nvidia l’a vendu comme tel, comme l’écrit CNN en 1999, lors de la sortie de la carte. En 25 ans, Nvidia est devenu chef du marché, et s’est également imposé dans l’histoire.

Une fiche technique ridicule par rapport aux GPU actuels

Sa fiche technique est évidemment risible comparée aux fiches techniques des GPU les moins chers aujourd’hui : gravure avec une finesse de 220 nanomètres et une fréquence d’horloge de 120 MHz.

Aujourd’hui, on ne parle plus en centaines (on parlait même de micromètres !), ni en dizaines de nanomètres, et plus en MHz. On parle de gravures qui s’approchent des 2 et 3 nanomètres, et de fréquences qui s’expriment en GHz.

Nvidia affirmait il y a un quart de siècle être capable de traiter jusqu’à 10 millions de polygones par seconde : cela se chiffre désormais en milliards. 32 Mo de VRAM à l’époque, contre 24 Go sur les modèles actuels les plus avancés. Jour et nuit.

La GeForce 256 était vendue 1890 francs à la fin des années 1990, soit environ 300 euros, selon les calculs de Compteur de matériel. En raison de l’inflation, cela représenterait environ 423 euros en 2023. Aujourd’hui, les prix se sont envolés : il faut parfois débourser 1000 euros ou plus pour une grosse carte graphique, ou on a de la chance. Les cartes graphiques étaient meilleures avant en termes de prix.

GeForce 256 : le synonyme d’une révolution matériel

Déjà en août 1999, Marc Prieur de HardWare.com dit: » une chose est sûre, une révolution se prépare dans le petit monde de la 3D sur PC. » Depuis, la concurrence, principalement d’AMD, est arrivée : « toujours plus, toujours mieux, c’est ce que semblent nous promettre les fabricants de puces graphiques avec cette nouvelle technologie. »

Alors qu’à la fin des années 1990, un Pentium III 600 coûtait 6000 francs, la carte graphique de Nvidia apparaissait comme une solution moins chère et plus efficace (elle pouvait calculer quatre fois plus de polygones par seconde). Pour Marc Prieur, c’était certain : Nvidia avait « clairement une longueur d’avance sur la concurrence », écrivait-il il y a vingt-cinq ans. Ce que cela a apporté aux joueurs du monde entier (d’abord avec les cartes du fabricant, puis avec AMD), ce sont des textures plus précises, un éclairage dynamique plus fluide et plus d’images par seconde.

Sans cette révolution, il n’y aurait pas d’e-sport ni de jeu vidéo sur Twitch/YouTube (ou presque). Pas de bitcoins ni de minage aussi rapide (mais cela aurait aussi peut-être évité les ruptures de stock que l’on a connues il y a quelques années). Il n’y aurait peut-être pas eu d’utilisations aussi avancées de l’intelligence artificielle, notamment de l’IA générative.