Comment fonctionne « Pixel Screenshots », l’outil d’analyse de vos captures d’écran ?

Lors de la présentation du Pixel 9, Google a rapidement évoqué l’existence d’une nouvelle fonctionnalité alimentée par l’IA : Pixel Screenshots. On en sait un peu plus sur son fonctionnement.

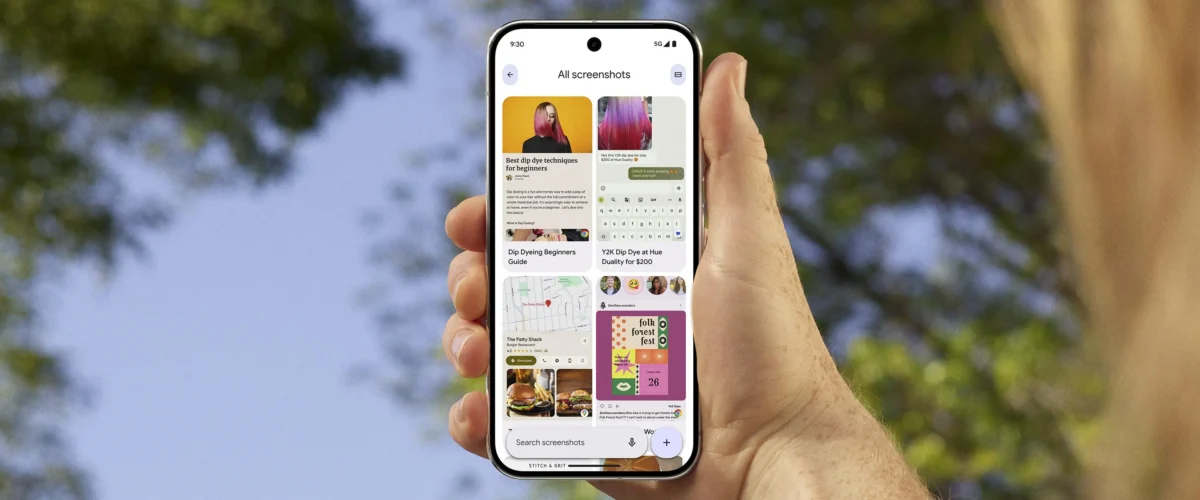

Vous cherchez désespérément la photo de ce tweet amusant que vous avez vu il y a trois heures, mais vous n’arrivez pas à la retrouver ? Pas de panique, Pixel Screenshots va vous aider à faire le tri dans la mémoire de votre téléphone. Cette fonctionnalité, exclusive pour l’instant aux Pixel 9, a été présentée le 13 août lors de la conférence de présentation des nouveaux mobiles. Autorité Android j’ai réussi à regarder un peu sous le capot de l’outil.

En principe, Pixel Screenshots fonctionne de manière très simple. Chaque fois que vous prenez une capture d’écran, votre téléphone analyse l’image et la rend « consultable » en indexant le contenu textuel et image s’il y en a.

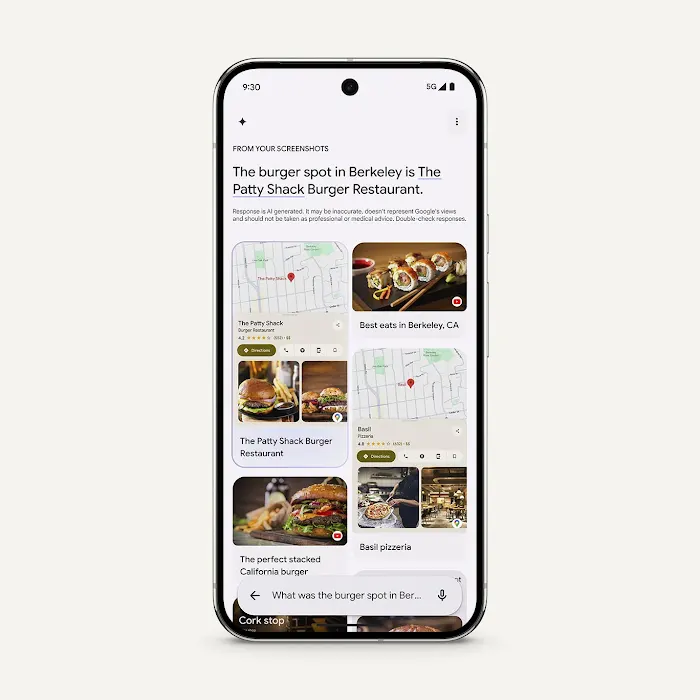

Ainsi, si vous avez pris une capture d’écran d’un message contenant le code d’entrée de votre maison de vacances, il vous suffit de lancer l’application Google et de rechercher quelque chose de contextuel (comme « message », « code » ou quelque chose comme ça) et l’application affichera les informations stockées sur le téléphone.

Limité à 15 captures par jour

Le fonctionnement de l’outil rappelle beaucoup Recall, la fonctionnalité annoncée puis abandonnée récemment par Microsoft. Mais en pratique, Pixel Screenshots fait les choses tout autrement (et c’est tant mieux). Tout d’abord, l’application ne décrypte que 15 captures d’écran par jour maximum. La limite a été fixée à la fois pour éviter de trop envahir votre vie privée comme le faisait la solution de Microsoft, mais aussi pour des raisons plus bêtement techniques.

Le décryptage des captures d’écran étant effectué localement grâce au modèle multimodal Gemini Nano, chaque image nécessite 15 à 20 secondes de traitement pour être indexable. Pour éviter de surchauffer l’appareil, de vider la batterie ou de monopoliser le processeur, Pixel Screenshots est volontairement bridé. Si vous prenez plus de 15 captures d’écran par jour, le téléphone ne traitera les données qu’une fois en veille et en charge.

Pixel 9 uniquement (pour l’instant)

Il sera toujours possible de « forcer » le traitement d’une image en ouvrant l’application, mais par défaut Google se limitera à 15 captures, ce qui devrait suffire à couvrir les usages d’une grande partie des mobinautes.

Pour aller plus loin

Google « intègre Gemini au cœur d’Android » : les meilleures nouvelles fonctionnalités d’IA sur le Pixel 9

Pour l’instant, le modèle d’IA utilisé par Pixel Screenshots n’est disponible que sur les Pixel 9, 9 Pro et 9 Pro Fold. Il apparaîtra peut-être sur les modèles précédents de téléphones Google, si l’entreprise décide qu’elle a suffisamment de puissance pour digérer l’analyse des captures d’écran sans compromettre les fonctionnalités de l’appareil.